一、从数据维度做拆分,让目标更加落地。

我做过近两年的电商运营,其中感触很深的一个点就是从数据的维度对目标做拆分。

天猫的双11刚刚过去,马云又创造了新的成绩,912亿。从去年的571亿到今年的912亿,马云怎么就敢说今年可以做900亿呢?在设定这个目标之前就少不了对目标的拆分。

900亿的成交,首先按照过往的类目占比,拆分到各个类目,每个类目承担多少销售指标,类目再按照过往的卖家成交额占比拆分到各个卖家,每个卖家承担多少销售指标。卖家再根据各自的日常店铺转化率反推需要多少流量,各类目再结合平台能提供的流量,就可以得到流量的缺口。接下来再按照各渠道获取流量的成本来计算,就可以得出双11平台需投入的营销经费数值。整个900亿的目标,通过这样的拆分,就变得明确可执行了。

无论做什么事情,想做成,都离不开对目标的拆解,任何抽象的事物都可以通过数学的方法来解决,把事情数据化会让事情更简单可执行,也更容易考核效果。

二、很多业务其实就是一个公式。

我刚开始接触电商接受业务培训,第一节课就只讲了一个公式。

成交额=买家数x客单价

如果你想提升成交额,要么提升买家数,要么提升客单价。我们可以盘点一下,我们见过这么多的促销手段,有哪个不是为了提升这两个数值的。满减、满送、买二送一,这是为了提升客单价的手段;秒杀,团购,这是为了提升买家数的手段(秒杀的核心在于集聚大量流量做关联销售)。

不仅仅如此,这个公式依据不同的业务场景还可以拆分成多种形式。

买家数 = 商详uv x 下单率 x 付款率

商详uv = 广告展现 x 广告转化率 = 搜索展现x搜索转化率 = 活动展现x活动点击率

于是,决定成交额的因素就变成了各个渠道的转化率、图片的点击率、产品的下单率、付款率,这样多的细节共同决定了最后的成交额。接下来针对这些细节分别去做优化,这个过程就叫依据数据做精细化运营。

仔细想想,你自己的业务又何尝不是一个公式呢?试着找到自己的公式,去拆分它,你也许会不少改进的方法。

三、运营说到底就是一个漏斗。

互联网的模式下,无论做什么产品,根本目的都是为了变现,只要是变现,就涉及到了转化。而转化其实就是一个漏斗模型。

漏斗模型是运营数据里提到的最多的词了,在业务的链条里,每个环节的用户数是呈不断衰减的,运营要做的事,就是想尽一切的办法来提升漏斗中各环节的转化率。

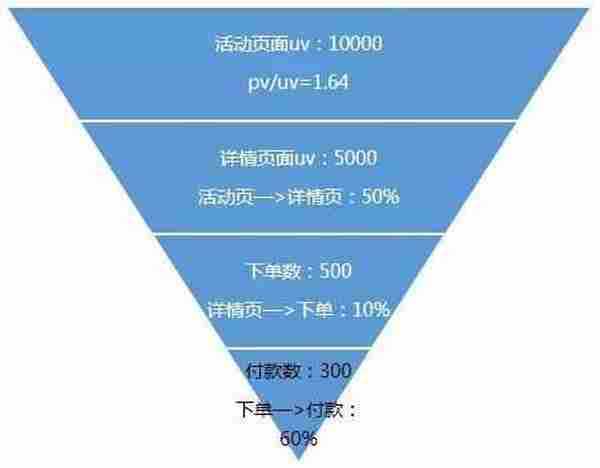

比如一个电商的活动页,它的漏斗模型应该是这样的:

有了这么个漏斗,我就可以分析每个环节代表了什么,我怎样去改善:

1)pv/uv:页面访问深度,直接体现了这个页面是否吸引人,用户在这个页面是否产生点击的兴趣。

2)活动页—>详情页uv:页面上的内容是否吸引人,商品是否是用户喜欢的,需根据页面点击情况及时替换点击效果差的商品。

3)详情页uv—>下单人数:商品的转化率如何,是不是爆款,此处转化过低需替换高转化的商品。

4)下单人数—>付款人数:商品的付款率,如果低于正常值,需要卖家催单。

需要注意的是,漏斗模型是需要对比的,如果仅仅只有一个漏斗模型,那么就只是数据的陈列,如果要做分析的话,就一定要有对比,比如和往期的漏斗作对比,比如与平台的均值作对比,只有在对比过程中才会发现问题。我们作为产品运营的同学,必须要熟悉我们产品中每一个关键数据,日均的uv是多少、转化率是多少,下载量是多少,这样在数据出现异常的时候才可以第一时间发现,熟悉产品数据,是对数据敏感的前提。

四、一篇完整的数据分析报告应该包含哪些内容?

前面讲了一些理论层面的,最后给一个数据分析模板给大家,供参考。

1、首先你需要根据活动目标确定你的目标达成率,完成百分比,提升百分比。这是这次活动取得的成果,在一开始就写。如:

本次活动 uv 24w(20w,↑ 20%),uv价值 3.6(3,↑ 20%)

2、如果是发周报、月报之类的数据,接下来就应该是核心数据走势图

在这张图里,要对每个数据的拐点做分析,比如图中11月7日、8日两天的uv价值有明显提升,这个的原因,要找到并写在报告里。

3、接下来流量分析,主要为流量来源分布,各渠道流量转化率分析。流量涨了,要找到是哪个渠道带来的流量涨了,为什么涨了,分析这里的原因。流量的质量如何,哪个渠道的流量转化率高。这里需要两个饼图,一个是流量渠道占比,一个是渠道带来的转化占比。

从上面的两个饼图里,我们看到明显站内流量的转化率更高,而广点通带来的流量转化率偏低。另外,通过与往期的渠道来源占比作比较,我们可以看到当前流量构成上的变化。

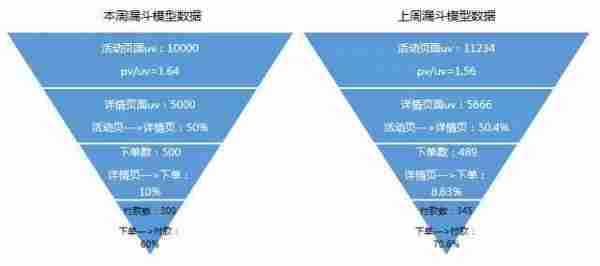

3、转化率分析,也就是漏斗模型分析。前文提到了,漏斗模型需要对比的数据,所以在此处的分析,我们需要列两个漏斗模型。

对漏斗模型各环节转化的分析,这里主要和往期数据做对比,结合活动页面、流量、产品功能等多方面因素,尝试分析这里各环节转化率提升或者降低的原因。

4、模块点击分析

我们设计的产品页面,或者活动页面,我们需要知道这个页面的结构是否合理,用户的点击分布,这有助于我们改善。当我们尝试新的页面样式的时候,更应该对这里的模块点击做分析,可以验证我们的结构是否对数据带来了改善。

模块点击分析主要是从点击饼图,及其各模块转化率的角度来分析,点击饼图可以看到用户的需求,模块转化率则反应了各个模块内容是否满足用户的需求,如果模块转化率较低,则需要考虑这个模块的内容是否优质,甚至这个模块是否需要改变样式。

5、改进及优化

每次的活动总是有做的好的地方和做的不好的地方,我们数据分析的目的就是为了积累经验,沉淀方法论,在每一篇数据报告的结尾,我们需要对这一次活动做一个总结,比如尝试了一个新的玩法,效果如何,尝试了一个新的页面样式,点击率是否有提升,等等。把经验应用于之后的活动策划当中。

五、数据不是万能的

写在最后,想说一点,数据不是万能的。

我们常做的数据分析,是建立在海量数据的情况下,但往往在初创公司,数据系统还不完善,数据量不够的情况下,数据只能作为参考,过分相信数据往往会导致做出错误的判断。

数据有很多指标,统计维度又有很多种,如果深挖下去,会耗费大量的精力,但却不一定会有成效,所以找出最关键的几个数据指标,对其最合理地分析,这点很重要。

今天就说这么多啦。做数据分析,重点不在数据,而在分析,对数据敏感,就是能清楚数据异常背后的原因,这需要经验,也需要你的思考和执行力。希望你可以成为一个对数据敏感的互联网人。

免责声明:本站资源来自互联网收集,仅供用于学习和交流,请遵循相关法律法规,本站一切资源不代表本站立场,如有侵权、后门、不妥请联系本站删除!

RTX 5090要首发 性能要翻倍!三星展示GDDR7显存

三星在GTC上展示了专为下一代游戏GPU设计的GDDR7内存。

首次推出的GDDR7内存模块密度为16GB,每个模块容量为2GB。其速度预设为32 Gbps(PAM3),但也可以降至28 Gbps,以提高产量和初始阶段的整体性能和成本效益。

据三星表示,GDDR7内存的能效将提高20%,同时工作电压仅为1.1V,低于标准的1.2V。通过采用更新的封装材料和优化的电路设计,使得在高速运行时的发热量降低,GDDR7的热阻比GDDR6降低了70%。

更新日志

- 小骆驼-《草原狼2(蓝光CD)》[原抓WAV+CUE]

- 群星《欢迎来到我身边 电影原声专辑》[320K/MP3][105.02MB]

- 群星《欢迎来到我身边 电影原声专辑》[FLAC/分轨][480.9MB]

- 雷婷《梦里蓝天HQⅡ》 2023头版限量编号低速原抓[WAV+CUE][463M]

- 群星《2024好听新歌42》AI调整音效【WAV分轨】

- 王思雨-《思念陪着鸿雁飞》WAV

- 王思雨《喜马拉雅HQ》头版限量编号[WAV+CUE]

- 李健《无时无刻》[WAV+CUE][590M]

- 陈奕迅《酝酿》[WAV分轨][502M]

- 卓依婷《化蝶》2CD[WAV+CUE][1.1G]

- 群星《吉他王(黑胶CD)》[WAV+CUE]

- 齐秦《穿乐(穿越)》[WAV+CUE]

- 发烧珍品《数位CD音响测试-动向效果(九)》【WAV+CUE】

- 邝美云《邝美云精装歌集》[DSF][1.6G]

- 吕方《爱一回伤一回》[WAV+CUE][454M]